Управлять корпоративной информацией — значит эффективно ее организовать и использовать на благо бизнеса. Наряду с количественными, или структурированными, данными, которые можно собрать и упорядочить в таблицах, большая часть информации представлена огромным количеством документов, электронных писем, видео и др., что называют неструктурированным контентом. Он не менее важен, но бизнесу еще предстоит научиться систематизировать и использовать его с помощью новых технологий и инструментов обработки данных. Один из них — Big Data. В чем полезность таких инструментов, каковы финансовые и организационные выгоды их применения на практике? И всегда ли нужны сложные системы? На эти вопросы ответили эксперты известных компаний-разработчиков в рамках обсуждения возможностей, различных сценариев и примеров использования аналитических технологий1.

Чтобы заранее оценить последствия принятых решений, к любому вопросу нужно подходить взвешенно, обсудить его с разных сторон, понять плюсы и минусы. Без «эмпирических взвешиваний» не обойтись и в понимании новых технологий работы с данными. А поскольку сомнения есть всегда, то и разобраться с ними лучше в первую очередь.

Подвергай все сомнению и формулируй правильные вопросы

Так начал дискуссию ее ведущий, Станислав Макаров, аналитик PCWeek, член экспертного совета DOCFLOW:

— В большей мере, на мой взгляд, Big Data есть результат агрессивной маркетинговой стратегии и лихорадки. Тактика вендоров такова: вначале напугать заказчика огромными темпами роста информации и ее объемами (зеттабайт (Zetb) и йотабайт (Yotb), встречается даже бротнобайт (Brontb) и геопбайт). Каждые пять лет объем информации увеличивается в несколько раз. Причем одни и те же данные хранятся в огромном количестве копий. Например, фото лондонского Big Ben занимает в интернете объем в ¼ петабайта. А сколько в этом объеме полезной информации? И что произойдет, если дедуплицировать весь интернет? На уровне компаний сокращение объемов хранения бывает в десятки раз.

В то же время способность людей потреблять информацию не выросла — за день можно просмотреть несколько фильмов или прочитать пару сотен страниц. При изобилии данных всегда есть риск, что человек не сможет отделить существенную информацию от несущественной. И для бизнеса это основная проблема.

Отсюда вывод: подвергай все сомнению и формулируй правильные вопросы!

Насколько информация уникальна?

Какую пользу из нее можно извлечь?

Как долго ее нужно хранить?

К тому же в отсутствие надежных моделей обнаруженные при помощи Big Data закономерности могут оказаться мнимыми. Чудес не бывает: из большой кучи данных теория сама собой не построится.

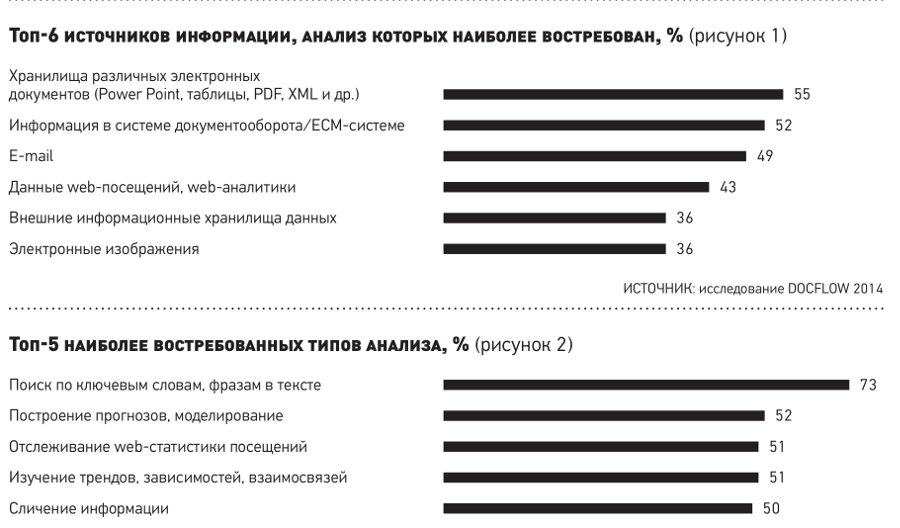

И все же есть надежда — запрос рынка на аналитику есть, и проявляется он в наиболее востребованных источниках информации и типах анализа, приведенных на рис. 1 и 2.

Казалось бы, что общего между управлением информацией и электронным документооборотом? Дело в том, что взрывной рост объемов данных вызван в первую очередь ростом неструктурированной информации, 80—90% полезной для бизнеса информации хранится в неструктурированном виде. Поэтому Big Data и Big Content соотносятся как структурированная информация (данные) и неструктурированная информация (контент, содержание). Иначе говоря, Big Data = Big Content.

Казалось бы, что общего между управлением информацией и электронным документооборотом? Дело в том, что взрывной рост объемов данных вызван в первую очередь ростом неструктурированной информации, 80—90% полезной для бизнеса информации хранится в неструктурированном виде. Поэтому Big Data и Big Content соотносятся как структурированная информация (данные) и неструктурированная информация (контент, содержание). Иначе говоря, Big Data = Big Content.

Долгое время усилия в бизнесе были сконцентрированы на регистрации, хранении информации и на ее использовании непосредственно в бизнес-процессе. Большая работа проделана в основном со структурированной информацией, меньшая — с неструктурированной, для ее интерпретации не было инструментов. Вместе с тем большие объемы структурированных и неструктурированных данных породили системы вовлеченности.

В то же время аналитические технологии (Hadoop и NoSQL) драматически снизили стоимость обработки огромных массивов данных. А прогресс в семантике, поиске контентной и текстовой аналитики впервые сделал возможным анализ неструктурированной информации. Впервые достигнуто сочетание доступности благодаря облакам и понятности за счет аналитических технологий BI.

Раньше СЭД не «понимал» внутренней структуры документа и работал только с карточками (метаданные). Теперь документ больше не является черным ящиком. Аналитическая система работает как с метаданными, так и непосредственно с контентом документа, что и внушает надежду на прогресс в технологиях ECM.

Новые технологии и инструменты Big Data позволяют решать задачи дешевле, быстрее и эффективнее

Такое мнение высказал Андрей Пивоваров, руководитель группы перспективных технологий, Oracle СНГ, и обосновал его так:

— Аналитика и хранилища данных используются и применяются в России уже много лет. С Big Data вопрос немного сложнее и начать нужно с терминологии. Четкого определения нет, разные компании и вендоры трактуют Big Data по-своему, часто определяя их через 3V (Velocity, Variety, Volume), что не совсем похоже на определение. В любом случае, Big Data — это новые возможности, ставшие доступными благодаря новым технологиям или подходам к обработке больших объемов данных, и новые инструменты, позволяющие делать то, что раньше было невозможно, либо делать то, что раньше было возможно, но теперь это стало гораздо дешевле или быстрее.

Есть задачи в области аналитики, которые существовали и 10, и 20 и, может быть, 100 лет назад, но сейчас появились технологии, которые позволяют решать их по-новому. Дешевле, быстрее или эффективнее. Например, десять лет назад обработка и анализ 100 терабайтов неструктурированных данных (тестов, логов, документов и т.д.) были ближе к области теории, а сейчас даже не очень большая организация или компания могут себе позволить это благодаря новым технологиям.

У разных технологий есть свои плюсы и минусы. Новые технологии, такие как Hadoop, позволяют удобно и дешево хранить и обрабатывать массивы полуструктурированных и даже неструктурированных данных. Вместе с тем традиционные транзакционные данные удобнее обрабатывать при помощи реляционных СУБД, и пользователи привыкли к определенным инструментам для работы с ними. Новые же технологии (Hadoop или NoSQL) предполагают другие подходы и инструменты. В чем отличие?

Традиционные технологии, такие как реляционные базы данных, зарекомендовали себя как надежные платформы для хранения, обработки и анализа данных, которые перед загрузкой должны быть структурированы. Но в последнее время все чаще появляются задачи, связанные с обработкой текстов, логов, аудио и видео, данных, занимающих большие объемы и не структурированных в понимании реляционных СУБД.

Приведу несколько примеров сценариев использования «больших данных»:

- сбор и анализ очень детальных данных о клиентах с целью создания более точных предложений или продуктов для конкретного клиента;

- задачи, связанные с безопасностью, например предотвращение мошенничества, что также требует анализа огромного объема данных, и чем больше этих данных есть, тем лучше;

- решение прежних задач, которые теперь можно делать в десятки раз дешевле в расчете на единицу объема данных (гигабайт, терабайт, петабайт).

Эффективность использования технологии Big Data часто связана со стоимостью обработки данных. Сейчас мы можем решать те или иные задачи, анализируя данные, скажем, в десять раз дешевле, чем это было раньше. Но могут появиться (и появляются) сценарии использования, которые раньше были просто экономически не выгодны, а сейчас они уже могут приносить ощутимый эффект. Например, раньше делать персонализированное предложение каждому конкретному клиенту было просто технически невозможно и экономически не выгодно, поэтому клиентов разбивали на группы, сегменты и т.п. Теперь можно действительно проанализировать данные о конкретном клиенте и сделать предложение, интересное именно ему.

В конце прошлого года мы проводили исследование, во время которого опросили 108 российских компаний из разных отраслей (банки, телеком, ретейл, производство, госпредприятия). 37% ответили, что уже в том или ином виде используют технологии Big Data (20% используют в своей работе, и 17% активно экспериментируют). Еще 36% серьезно думают об использовании этих технологий. Среди опрошенных чаще других используют Big Data телекомкомпании и банки. Результаты исследования говорят, что Big Data в России уже превращаются из экзотики в серьезный инструмент бизнеса.

Важно идти от актуальных задач бизнеса, а не от продуктов и технологий

В этом убежден Дмитрий Романов, генеральный директор, «Преферентум» (ГК «АйТи»), доцент НИУ ВШЭ. И вот его доказательства:

— Долгое время я занимался документооборотом, архивами и часто сталкивался с тенденцией в маркетинге продавать заказчику одни и те же вещи, под разными названиями. Эта же тенденция играет заметную роль в пропаганде Big Data. На самом деле в большинстве компаний оперируют не очень большими объемами данных (от гига- до терабайтов).

Важно идти от актуальных задач бизнеса, которые можно решать с помощью современных технологий анализа и работы с информацией, в том числе с неструктурированными данными, а не от продуктов и технологий.

При этом сложные системы нужны там, где действительно есть «большие данные», например в социальных сетях. Многие задачи, связанные с применением аналитических технологий, можно решать гораздо проще и без применения сложных систем.

Например, сейчас значительно проще и быстрее найти какую-то информацию в интернете, чем нужный документ в своей организации. Корпоративная поисковая система решает эту задачу. А еще лучше по запросу и ключевому слову найти не 10 000 документов, а трех-четырех человек, компетентных в данной теме, которые смогут ответить вам на тот или иной вопрос. Задача по поиску компетентных людей внутри компании успешно решается с помощью индексирования корпоративной электронной почты.

Другой пример: при электронном согласовании документов (договоров, смет, спецификаций, накладных и др.) приходится исправлять много простых и мелких ошибок в расчетах и реквизитах, выявлять нестыковки в формулировках. Ручная сверка очень трудоемка и чревата появлением ошибок. Современные технологии избавляют человека от таких мелочей, высвобождая его время на творческие задачи.

Задача автоматической классификации документов — еще одно из направлений применения аналитических технологий. На примере имеющегося хранилища документов можно обучить систему и автоматически направлять входящие документы по тем подразделениям, которым они нужны.

Всем знакома навязчивая контекстная реклама, заполняющая страницы браузеров. Эта же технология, но применяемая в интересах пользователя, позволяет в режиме реального времени индексировать создаваемые документы и получаемые письма, учитывать его интересы и формировать, подстраивать, группировать для него различные потоки информации, в том числе новостные рассылки.

Есть много и других возможностей применения современных аналитических технологий, доступных уже сейчас. Они позволяют решать реальные практические задачи, стоящие как перед каждым сотрудником, так и перед функциональными службами современной организации — HR, R&D, S&M, IT, юристами, информационной безопасностью и т.п. И не имеет значения, называется эта технология Big Data или нет.

На мой взгляд, технологии должны опережать средние текущие потребности бизнеса. А внедрять в практическое использование нужно то, что принесет выгоду: сократит издержки, снизит риски, откроет новые возможности для развития.

Как применить технологии «больших данных» и увеличить экономический эффект от их внедрения?

Именно эти вопросы уже решают заказчики и партнеры компании Pivotal, поскольку вопросы «Что такое Big Data? Зачем нужны „большие данные“? Как их обрабатывать?» для них остались уже в прошлом, утверждает Сергей Золотарев, глава представительства компании в России и странах СНГ. Вот его мнение:

— Ценность Big Data в том, что можно создавать ИТ-системы нового типа, выводить их на рынок и достигать эффекта за счет трансформирования стандартных предприятий в новый тип компаний, готовых к изменениям цифровой экономики.

Сейчас наступила эра принципиально других бизнесов, так называемой третьей платформы, которая характеризуется бумом в области мобильных технологий, социальных сетей, многократного увеличения количества приложений. Пользователям сегодня нужна доступность бизнеса в режиме 24/7, возможность получить услугу сразу же. Технологии Big Data оптимальны именно для таких условий ведения бизнеса: инструменты сбора, анализа данных могут быть схожи, но результат напрямую зависит от готовности бизнеса принять эти изменения.

Для понимания, зачем нам нужны «большие данные», лучше обратиться к конкретным кейсам. Сами технологии — это как таблетка от головной боли, которая нужна, но не всем. Традиционно ИТ-емкие бизнесы, такие как банки и телекоммуникационные компании, одни из первых ощутили на себе необходимость внедрения и последующий эффект от «больших данных». Мы сотрудничали с одним из банков, который построил свой бизнес в рамках третьей платформы, отказался от традиционных банковских отделений и перешел к интернет-обслуживанию. Это позволило сфокусироваться на анализе пользовательского поведения, улучшить сервис, сократить издержки и минимизировать экономические риски. Ряд крупнейших финансовых структур в мире называют себя ИТ-компаниями, подразумевая именно переход к такому «виртуальному» способу предоставления услуг.

Сейчас идет следующая волна внедрения Big Data. В мире ее начали использовать ведущие мировые корпорации, например General Electric, производящая оборудование для таких отраслей, как энергетика, машиностроение, самолетостроение. Информация, которую генерируют огромное количество двигателей и самолетов, не только большая в количественном выражении, но и критически важная для анализа, поскольку работа с подобным оборудованием несет очень большие риски. В GE посчитали, что при снижении затрат на обслуживание оборудования на 1—2% экономия достигает миллиардов долларов. С этим был связан переход методологии по замене запчастей на оборудовании по регламенту к замене их по фактическому состоянию. В этом GE помог совместный с нашей компанией проект в области Big Data. Такой пример можно использовать в экономике в целом, ведь более эффективное использование ресурсов всего на 1—2% может дать колоссальный эффект, и для этого обязательно потребуется работа с «большими данными».

Современные лингвистические технологии позволяют отделить важную информацию от информационного шума

Обработка Big Data становится все более актуальной особенно для крупных компаний, считает Максим Михайлов, старший вице-президент, директор департамента ABBYY Compreno. Вот его аргументы:

— По данным IDG, к 2020 г. объем цифровых данных в мире превысит 35 000 эксабайтов, из которых более 80% будут неструктурированными. И уже сегодня 78% организаций во всем мире уделяют особое внимание структурированию данных, отмечают аналитики IDG Enterprise2.

Количество же компаний, внедривших решения по анализу данных, возросло за прошедший год на 125%. Технологии анализа данных позволяют увеличить на:

- 61% качество принятия бизнес-решений;

- 57% точность при планировании и прогнозировании;

- 51% скорость принятия решений в компании.

Обрабатывать и анализировать массивы неструктурированных данных позволяют и современные лингвистические технологии, что важно при анализе как внешних, так и внутренних, корпоративных источников информации.

Одним из ярких примеров использования такой технологии для анализа внешних источников данных — объектная оценка мнений в социальных сетях для мониторинга отношения клиентов к бренду компании, ее продуктам. Автоматизируя этот процесс, современные корпорации выстраивают обратную связь с рынком, быстрее и точнее реагируют на желания клиентов и в конечном итоге повышают лояльность. При этом необходимо отделить действительно важную информацию от информационного шума. Распознавая смысл текста, лингвистические технологии помогают определить его объектно-ориентированную тональность — понять, чем конкретно доволен или недоволен клиент. Такая задача актуальна для компаний, работающих с большим числом клиентов, например банков, мобильных операторов, розничных сетей, производителей товаров FMCG и т.п.

Кроме того, в информационных системах крупных компаний хранится огромное количество данных, накопленных за время их существования. Такие данные прирастают высокими темпами, создавая новые вызовы. И возможность быстро обрабатывать информацию, содержащуюся в неструктурированных текстах, например в договорах, приказах, отчетах, письмах, становится для них критичной.

Оптимизация документооборота — пример анализа внутренних источников данных.

Возможность выделять в тексте важную для анализа и принятия решения информацию (сущности, объекты, события и связи между ними) важна для решения многих прикладных задач. Например, создание карточки договора, формирование аналитических отчетов службы безопасности, дополнение данных в СЭД/ECM, биллинговые системы, управление рисками в банковской отрасли, автоматизация проверки проектно-сметной документации и др.

Еще одна перспективная и интересная сфера применения — решение задач, связанных с визуализацией текста. Создание мультипликационных роликов и фильмов на основе текстовых сценариев — яркий тому пример.

К сведению

Примерная хронология единиц измерения объемов информации:

с 2005 по 2010 гг.:

- Gigabyte (GB — 109);

- Terabyte (TB — 1012);

- Petabyte (PB — 1015);

- Exabyte (EB — 1018), для сравнения: Internet = 1 EB/день.

В 2015 г.:

- Zettabyte (ZB — 1021);

- Yottabyte (YB — 1024).

К 2020 г. ожидается:

- Brontobyte (BB — 1027);

к 2025 г.:

- Geopbyte (GpB — 1030).

1 Дискуссия состоялась на ежегодной конференции-выставке по управлению информационными ресурсами и электронным документооборотом DOCFOW-2015.

2 IDG Enterpise — аналитическое подразделение медиахолдинга IDG, в который входят издания Computerworld, ITworld, CIO и др.